PNO - Khi phân tích các bức ảnh chụp phụ nữ và nam giới khỏa thân, công cụ AI (trí tuệ nhân tạo) của các tập đoàn công nghệ lớn đã thể hiện rõ thái độ định kiến giới.

| Chia sẻ bài viết: |

Vì sao cuộc săn lùng nàng tiên cá vẫn nóng đến giờ?

'Người tình bất tử' - Bí ẩn tình yêu lớn nhất cuộc đời thiên tài âm nhạc Beethoven

Chuyện tình bi thương phía sau kỳ quan Taj Mahal nổi tiếng ở Ấn Độ

Lịch sử bí ẩn của những hội kín kết nối người âm tại Mỹ

Bi kịch của cô gái người Đức bị cáo buộc quỷ ám

Cuộc sống của bóng hồng sau lưng các phi hành gia

Nhiều trường đại học ở Nhật Bản đang cung cấp các khóa học cho người cao tuổi khi ngày càng có nhiều người già đi học trở lại.

Ngày càng nhiều cử tri Nhật Bản sử dụng AI để hỗ trợ quyết định lựa chọn ứng viên hoặc đảng phái trong cuộc bầu cử Hạ viện sắp diễn ra.

Số người chết do tuyết rơi dày ở Nhật Bản lên tới 30. Trong đó, có một cụ bà 91 tuổi được tìm thấy dưới một đống tuyết cao 3 mét.

Ngày 3/2, con trai của Thái tử Na Uy bị đưa ra xét xử với cáo buộc cưỡng hiếp 4 phụ nữ và tấn công nhiều bạn gái cũ.

Cựu Tổng thống Mỹ Bill Clinton đã đồng ý ra điều trần trước Ủy ban Giám sát Hạ viện liên quan đến mối quan hệ của họ với Jeffrey Epstein.

Mạng xã hội Moltbook là nơi con người chỉ đóng vai "khán giả" thầm lặng, còn mọi bài đăng, cuộc tranh luận đều do các robot (AI) thực hiện.

Ngày càng nhiều người cao tuổi trên thế giới chọn sống theo mô hình “dưỡng già tại chỗ”, “sống già độc lập”.

Hơn 100.000 thường dân thiệt mạng trong 18 tháng qua, giữa lúc tội ác chiến tranh, bạo lực tình dục tiếp diễn tràn lan mà không có sự trừng phạt thích đáng.

Khi trí tuệ nhân tạo (AI) lan rộng với tốc độ chóng mặt, không phải ai cũng đón nhận công nghệ này với sự hào hứng như nhau.

Nước Mỹ đang trải qua một trong những đợt băng giá nghiêm trọng và kéo dài nhất trong hơn 6 thập kỷ.

Ngày 1/2, hơn 1.200 chuyến bay đã bị hủy trên khắp nước Mỹ do cơn bão mùa đông mạnh, gây ra lượng tuyết rơi dày tới hơn 30 cm ở nhiều vùng.

Người lao động, đặc biệt là giới trẻ, cần nhớ rằng, kỷ nguyên mới không dành cho sự thụ động.

Một nghiên cứu mới cảnh báo thiếu ngủ không chỉ khiến tinh thần uể oải mà còn gây ra những tổn thương vật lý thực sự cho cấu trúc não bộ.

Sau thời gian dài đối mặt với cuộc khủng hoảng nhân khẩu học, Hàn Quốc đang đón nhận luồng gió ấm khi tỉ lệ kết hôn và sinh con tăng mạnh.

Tại Nhật Bản, nhiều cụ bà đã ngoài 80 tuổi, thậm chí mắc chứng sa sút trí tuệ, vẫn đều đặn đi làm và kiếm thu nhập.

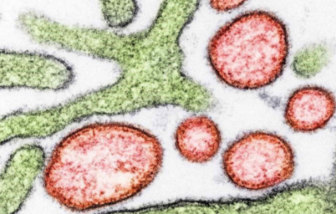

Giai đoạn thử nghiệm vắc xin ngừa vi rút Nipah

Taj Mahal – kiệt tác kiến trúc giữa lòng Agra – không chỉ là một trong bảy kỳ quan thế giới mà còn là dấu mốc của một bi kịch tình yêu.

Ở Ấn Độ, nước đóng chai cao cấp đã trở thành biểu tượng của sự sang trọng và sức khỏe mà người giàu có theo đuổi.