PNO - Trí tuệ nhân tạo (AI) đang len lỏi vào mọi ngóc ngách cuộc sống: từ viết báo cáo, gợi ý tài chính đến đóng vai “người yêu ảo”. Nhưng sự “ngoan ngoãn” quá mức của chatbot lại đang khiến nhiều người… phát chán.

| Chia sẻ bài viết: |

Dũng 06-10-2025 06:32:26

Bạn yêu cầu nó nói chuyện vô tri như trẻ lên 3 cũng được mà, đâu nhất thiết AI lúc nào cũng phải la người trả lời.

Phở bò 03-10-2025 10:23:41

Dùng Character.ai thích hơn :))

Lê Thị Uyển Chi 30-09-2025 09:06:02

Muốn ChatGPT không quá vâng lời, bạn hãy bảo nó bật chế độ "Đối thoại phản biện".

6 vụ mất tích bí ẩn ở vùng biển New Zealand

Vì sao tình báo Iran tê liệt khi Mỹ-Israel không kích khiến hàng loạt chỉ huy thiệt mạng?

Vì sao cuộc săn lùng nàng tiên cá vẫn nóng đến giờ?

'Người tình bất tử' - Bí ẩn tình yêu lớn nhất cuộc đời thiên tài âm nhạc Beethoven

Chuyện tình bi thương phía sau kỳ quan Taj Mahal nổi tiếng ở Ấn Độ

Lịch sử bí ẩn của những hội kín kết nối người âm tại Mỹ

Các chuyên gia pháp lý đã tỏ ra hoài nghi về thẩm quyền hiến pháp của Tổng thống Donald Trump trong việc phát động hành động quân sự mới vào Iran.

Các cuộc không kích của Mỹ và Israel khiến bốn lãnh đạo cấp cao chủ chốt của Iran thiệt mạng, đẩy tổ chức này vào tình trạng hỗn loạn.

Từ bỏ hoàn toàn chương trình hạt nhân sẽ khiến Iran phải đối mặt với sự ép buộc và các cuộc tấn công trong tương lai...

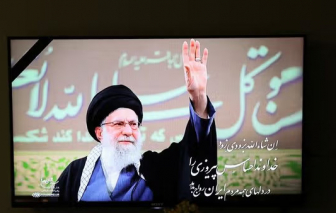

Thông tin về cái chết của Lãnh tụ tối cao Khamenei đã thổi bùng làn sóng cảm xúc trong xã hội Iran.

Cái chết của Lãnh tụ tối cao Ayatollah Ali Khamenei để lại một khoảng trống quyền lực khổng lồ do không có người thừa kế chính thức.

Nhiều phương tiện truyền thông nhà nước Iran đang xác nhận cái chết của Lãnh tụ tối cao Iran, Ayatollah Ali Khamenei.

Xu hướng “nuôi dạy cha mẹ” đang lan rộng trong giới trẻ Trung Quốc khi những người con trưởng thành trở thành người hướng dẫn, chăm sóc, “chữa lành” cho cha mẹ.

Tổng thống Mỹ Donald Trump tuyên bố ông tin rằng các báo cáo về cái chết của ông Khamenei là “chính xác”.

Giữa những tiếng bom đạn ở Trung Đông, nụ cười hồn nhiên của các bé học sinh tại thành phố Minab, miền Nam Iran, đã mãi mãi chìm trong im lặng.

Một xu hướng mới đang nổi lên trong lực lượng lao động trẻ tại Mỹ là Gen Z đưa cha mẹ đến các buổi phỏng vấn xin việc.

Quân đội Iran tuyên bố sẽ đưa ra “bài học mang tính lịch sử” cho Israel và Mỹ sau các cuộc tấn công nhằm vào một số thành phố của nước này.

Tình hình an ninh tại khu vực Trung Đông vừa có bước leo thang đáng ngại khi hàng loạt quốc gia vùng Vịnh đồng loạt thông báo đóng cửa không phận.

Tình hình Trung Đông vừa trải qua một đêm không ngủ khi căng thẳng giữa Iran và Israel bùng nổ thành cuộc đối đầu trực diện quy mô lớn ngày 28/2.

Thế giới vừa trải qua một ngày cuối tuần đầy biến động khi nhiều tiếng nổ làm rung chuyển Tehran, đánh dấu một nấc thang căng thẳng mới tại Trung Đông.

Tổng thống Donald Trump xác nhận trong một video đăng trên mạng xã hội rằng Mỹ đã bắt đầu một chiến dịch quân sự tại Iran.

Đòn tấn công đầu tiên dường như xảy ra gần các văn phòng của Lãnh tụ Tối cao Ayatollah Ali Khamenei.

Bộ trưởng Quốc phòng Israel Israel Katz tuyên bố Israel đã tiến hành một cuộc tấn công phủ đầu nhằm vào Iran, ban bố tình trạng khẩn cấp trên toàn quốc.

Sau nhiều năm rời xa giảng đường, hàng triệu người trưởng thành tại Mỹ đang quay lại trường học, tạo nên một xu hướng mới trong giáo dục đại học.